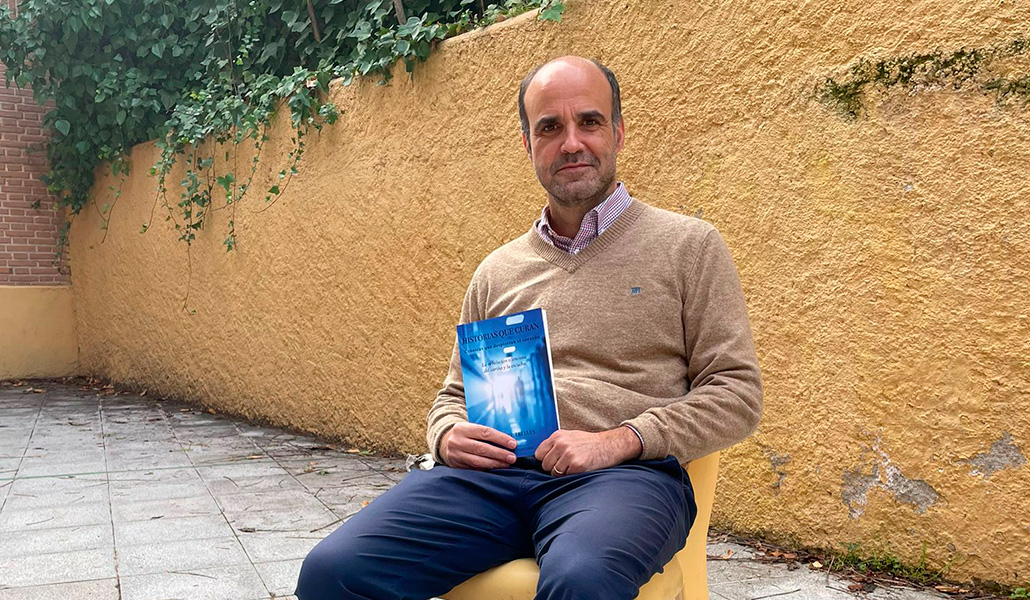

Manuel Alfonseca: «La inteligencia artificial no tiene nada de humana»

Manuel Alfonseca (Madrid, 1946) ha simultaneado 20 años de trabajo en IBM o la dirección de la Escuela Politécnica Superior de la Universidad Autónoma de Madrid con la publicación de más de 50 novelas. El ahora profesor honorario de la UAM es uno de los mayores especialistas en España sobre inteligencia y vida artificial, un campo en plena ebullición con colosales implicaciones éticas y religiosas

—¿La vida artificial es realmente vida, o solo una analogía?

—Es un nombre ambiguo, porque se puede confundir con la biología sintética, que es construir seres vivos artificiales. Esto es completamente distinto, y por supuesto analógico; no tiene nada que ver con la vida real. Lo que hacemos ahí es simular organismos que podríamos considerar vivos en un sentido amplio. Por ejemplo, programas informáticos que se reproducen y evolucionan.

—¿Cómo?

—Hacen copias de sí mismos y las ponen en marcha en otras zonas del espacio de memoria. Pero pueden introducirse mutaciones casuales y que el nuevo programa no sea idéntico. Si el cambio es tan grave que el nuevo organismo no sea capaz de reproducirse, lo acabará borrando otro. Ahí entra la selección natural. Y aparecen otras cosas muy curiosas, como programas parásito que utilizan el algoritmo de otro para reproducirse, y programas que evitan que otro se reproduzca utilizando su código.

—¿Todo ello sin intervención de los programadores?

—Exacto. Es solo un ejemplo, hay muchos más. El primero en inventar un programa así fue Tom Ray, con una máquina que tenía solo 16 instrucciones distintas. Curiosamente, el mismo programa se redujo y consiguió funcionar con menos instrucciones. Yo hice una versión más simple de su programa y comprobé todo eso.

—Estos mundos de bits, ¿se crean intentando conseguir algo, o simplemente por experimentación?

—Para ver qué pasa. Lo que ocurre es que luego se pueden sacar conclusiones sobre cómo aprovechar esta similitud con la evolución biológica para producir programas mejores. Con algoritmos genéticos, que llamamos así precisamente porque están relacionados con la evolución genética, podemos establecer una selección natural que nos lleve a lo que queremos obtener. Definimos una función de adecuación que marca la distancia que hay entre lo que el programa hace y lo que queremos que termine haciendo. Luego cogemos un programa, lo hacemos reproducirse con mutaciones y recombinaciones, y de todos los programas que salen nos quedamos con los mejores. Repetimos el ciclo, y se termina obteniendo.

—¿Obteniendo el qué, por ejemplo?

—Yo he trabajado en algoritmos genéticos para generar un programa que dibuje una curva fractal, la que sea, siempre que tenga una dimensión determinada. Pero también se puede aplicar en ingeniería, para diseñar por ejemplo una antena. Tú no sabes cómo va a ser, pero el programa evoluciona y, sin hacer tú los cálculos, diseña la antena que logra los efectos que tú has pedido. Otro experimento tiene que ver con simulación del comportamiento de organismos similares a las hormigas, pequeños pero muy numerosos, cuyos hormigueros pueden considerarse también seres vivos con intención o funcionalidad.

—¿Para qué?

—Nosotros estudiamos cómo influía en ellos el altruismo. Había hormigas altruistas, que cuando encontraban comida compartían la información con las demás, y no altruistas, de forma aleatoria. Descubrimos que cuando solo había un hormiguero, dominaban las no altruistas, porque tenían más comida y se reproducían más. Pero cuando había dos hormigueros o más en competencia, las hormigas altruistas hacían que su hormiguero creciera más. De aquí se deduce que el altruismo puede estar justificado biológicamente.

—También ha trabajado en inteligencia artificial, un campo distinto.

—Ahora está de moda llamar «inteligencia artificial» a lo que antes se llamaba informática, de forma que te dicen cosas tan absurdas como llamar «banco inteligente» a un asiento con una placa solar, un enchufe para recargar el móvil y un repetidor wifi. ¿Eso es inteligencia?

—Entonces, ¿cómo definirla realmente?

—La definición que dio John McCarthy cuando inventó el término en 1958 fue el tratamiento de información simbólica (textos o imágenes, no solamente números) por medios heurísticos: no simplemente mediante un algoritmo, sino por procedimientos que se deducen sobre la marcha y en función de los datos que se tienen.

—¿Son programas capaces de decidir?

—Más bien capaces de sacar conclusiones de los datos que tienen. Es un campo que ha variado mucho y ha pasado por unos altibajos tremendos. Cuando John McCarthy y sus compañeros crearon el concepto, predijeron que en diez años iba a haber traducción automática perfecta y programas capaces de ganar al campeón de ajedrez. Pasaron diez años, y nada de eso. Pareció que estaba todo demasiado lejos, y se dejó de trabajar en ello. En los años 1970 resurgió con la idea de los sistemas expertos: programas en los que, a base de reglas, se introducía información obtenida de seres humanos expertos en alguna materia. Pero era dificilísimo.

—¿Por qué?

—Porque no funcionamos así. Cuando le preguntas a un médico cómo diagnostica una enfermedad, te enumera síntomas. Pero si preguntas más, resulta que no siempre es así y la información se empieza a diversificar. En muchas ocasiones ni ellos saben lo que hacen, utilizan la intuición.

—¿Entonces, en qué se basa la inteligencia artificial actual?

—En el campo de las redes neuronales, que surgió en los 1980 y ha vuelto con mucha fuerza después de estar de baja forma en los 1990. Estas redes están formadas por programitas llamados neuronas, que se activan o no y así van distribuyendo el peso de la información que se les da sobre las múltiples uniones entre unas y otras; como las neuronas de verdad. Hay programas que enseñan a estas redes qué datos corresponden con qué resultado, y la red modifica las conexiones para que así sea. Así va ajustándose poco a poco, y cuando se le han dado quizá 100.000 problemas y ha sacado los resultados correctamente, termina la fase de aprendizaje y esa red se aplica a casos reales, utilizando toda la información acumulada.

—¿Qué tipo de casos reales?

—Si es recomendable conceder o no un crédito, o decisiones judiciales sobre prisión preventiva basándose en si es probable que una persona vuelva a reincidir. Otro ámbito en el que se ha utilizado es la traducción automática, cogiendo textos en distintos idiomas de internet y deduciendo cómo se traducen de una lengua a otra. Tradicionalmente la traducción automática era muy mala, en cuanto le dabas una frase hecha estabas perdido. Pero ahora lo han mejorado muchísimo y aunque no la resuelve del todo, es una buena herramienta para que luego un traductor humano la reescriba en menos tiempo. Lo que pasa es que internet es muy asimétrico: en español e inglés hay millones de textos y saca traducciones buenas. Pero se me ocurrió intentarlo con el texto latino de la fábula del zorro y las uvas, de Fedro. La traducción fue de risa. ¡Hasta salía sin motivo la palabra «César»! Mi hijo trabaja en Google y me dijo que el sistema habría deducido que esa palabra es importante en los textos latinos.

—¿Este es el sistema que está detrás de los coches autónomos?

—También, pero ahí además hay visión artificial que detecta la situación del automóvil, y a partir de ahí deduce cómo se tiene que mover.

—¡Las implicaciones éticas son tremendas!

—Depende de la aplicación, claro. Si es para tomar decisiones judiciales hay que mirarlo con mucho cuidado. Por un lado, la información es parcial: en el caso de la prisión preventiva, sabemos si delinquieron o no los detenidos que fueron puestos en libertad, pero no qué habría pasado con los que se envió a prisión preventiva. Además, esto tiene consecuencias sobre las personas, y solo puede ser una persona la que tome las decisiones. El juez puede ayudarse de un programa como este como una herramienta adicional que le proporciona más datos que los que tiene habitualmente. Pero si la decisión se le dejara al programa por sí solo, daría lugar a problemas éticos considerables.

—No hablemos ya de situaciones como aplicar esto a sistemas de armamentos, por ejemplo para elegir objetivos y cuándo atacar.

—Mejor no hablar de eso. La primera ley de la robótica de Asimov dice que un robot no debe causar daño a un ser humano ni consentir que lo sufra por su inacción. Pero con algunos colegas, algunos del MIT, hemos conseguido demostrar matemáticamente que no se puede cumplir. Es imposible crear un programa capaz de asegurar que otro no causará ese daño. Redujimos la primera ley de Asimov al problema de la parada que formuló Turing hace 80 años, y que es irresoluble.

—¿Y dónde nos deja eso?

—Los programas son como cualquier otra herramienta. Se pueden usar bien o mal, y si se usa mal la culpa es de quien lo usa: quien lo ha programado o quien lo utilice.

—¿La diferencia está solo en el potencial de generar daño?

—En la segunda guerra de Irak, las bombas de Estados Unidos casi no produjeron víctimas civiles, porque iban a un objetivo concreto y estallaban allí, a veces incluso avisando. Esto se podría hacer con mucha más exactitud.

—¿Pero podría ocurrir que un arma, o un coche, desarrollaran de algún modo criterios propios para decidir?

—Ahí entramos en otro campo, el de la inteligencia artificial fuerte, programas más inteligentes que los seres humanos y conscientes. Esta inteligencia artificial tiene una diferencia importantísima con la que hemos visto hasta ahora: no existe. Los programas, incluso los que aprenden y sacan conclusiones, no hacen más que seguir las instrucciones que se les han dado.

—¿Llegará a existir?

—Puede. Pero es una cuestión más filosófica que científica. Más que por la inteligencia, los seres humanos nos caracterizamos por la voluntad y la consciencia. Y que las máquinas lleguen a ser conscientes depende sobre todo de lo que entendamos por consciencia. Si es verdad la teoría del monismo materialista o determinista, que afirma que solo existe la materia, podremos construir máquinas más inteligentes que el hombre y conscientes, y no tardaremos mucho. Si quien tiene razón es el monismo emergentista, que dice que no todo se explica con el nivel más bajo de la materia pero sí combinando varios, tardaremos mucho. Ahora, si es verdad cualquier de las dos teorías dualistas sobre la realidad, que hablan de materia y espíritu bien totalmente independientes o que no pueden existir el uno sin el otro, jamás llegaremos a construir esas máquinas. Es lo que pienso yo. Cuando alguien sale diciendo que estamos al borde de tenerlas, habla sin ninguna base.

—¿Por qué piensa así, con todo lo que sabe sobre el funcionamiento interno de programas que aprenden, simulan el mundo real…?

—Precisamente por conocerlos te das cuenta de que todo eso no tiene nada que ver con el ser humano. Son herramientas, como una calculadora, sin mente. Es mentira que los robots tengan sentimientos: los simulan, los aparentan por cosas como el tono de voz. Pero siendo experto los veo por dentro y digo: «Esto no es».

—¿No se puede afirmar que cualitativamente es lo mismo, solo que añadiendo complejidad?

—Es lo que sostienen los monistas. Yo no estoy de acuerdo, pero científicamente no estamos en condiciones de demostrar una cosa ni la otra. El problema es que mucha gente confunde filosofía y ciencia, y afirma que «todo es materia» como si fuera algo científico. ¿Cómo vamos a demostrarlo, si la ciencia solo estudia la materia y no puede detectar cualquier cosa que estuviera fuera de ella? Es imposible que demuestre que Dios existe, o no. Cuando alguien hace una afirmación así está metiendo filosofía en la ciencia. Y es un abuso, aunque quizá se deba a la ignorancia.

—Puestos a compararnos con programas informáticos… ¿dónde está el Programador?

—Mi trabajo en vida artificial me ha dado muchas ideas sobre la evolución real. Y una de ellas es la contestación clara a quienes dicen que Dios no puede existir porque la evolución es un proceso aleatorio. En mis experimentos, utilizo el pseudoazar, un algoritmo que genera números que cumplen las condiciones de los aleatorios. Si fruto de la evolución de uno de mis programas llegaran a surgir seres con inteligencia artificial fuerte, basándose en ese pseudoazar podrían demostrar que yo no existo. Y si yo utilizo el azar para hacer evolucionar mis programas, ¿no puede hacerlo también Dios?

—Eso no es lo mismo que el diseño inteligente, ¿no?

—Hay tres posiciones: decir que Dios no existe porque hay azar en el mundo; la del diseño inteligente, que dice que podemos demostrar su existencia mirando la evolución y tampoco es científica, y la intermedia, la mía y de otros muchos: Dios existe y nos ha creado mediante una evolución en la que interviene el azar…, pero no se puede demostrar científicamente. Cuando hablé de esto en una conferencia, me escribió una chica iraní y me dijo: «Desde que trabajo en algoritmos genéticos, tengo clarísimo que Dios existe». ¡Porque nosotros estamos en su papel!

Cualquiera que pretenda demostrar que Dios no existe, demostraría que desde el punto de vista de nuestros programas no existimos nosotros. Sin embargo, como soy también novelista prefiero comparar la creación con una novela escrita por Dios. Lo que pasa es que Dios es mucho más eficiente que nosotros y ha hecho que sus personajes sean libres. Yo también querría hacer eso. Solo que no sé. Dios sí sabía, y lo hizo.

—Es la visión de la subcreación de J. R. R. Tolkien.

—Por ejemplo. Y hay indicios que apuntan a lo que debe de ser que los personajes sean libres. A Tolkien le pasó cuando están los hobbits en Bree y aparece un hombre que empieza a hablar con ellos. Cuenta que se preguntaba: «¿Quién es este? ¿Será bueno o malo?». Y era Aragorn, el rey de Gondor. A mí también me ha pasado que, aunque es evidente que al final todo ha salido de mi cerebro, cuando estoy escribiendo en algún momento da la impresión de que los personajes han hecho algo por sí mismos, independientemente de mi voluntad. Una vez, escribí «esto solo lo van a leer mi hermano y Vicky», y acto seguido me tuve que preguntar quién era Vicky. Me identifico mejor con Dios como novelista.

—¿Más que como programador?

—Al final es lo mismo. Si pudiera hacer que mis programas fueran libres… Escribí una novela sobre eso, La escala de Jacob, sobre un programa con componentes libres y conscientes. La conclusión es que para salvarlos, el programador tiene que introducirse en él y dar la vida por ellos [risas].

—También ha investigado en simulación informática.

—En ese campo trabajamos con programas informáticos que simulan sistemas (¡hasta el mismo universo!) para experimentar distintas teorías y ver si alguna se adapta a lo que vemos. Puede estar relacionada con la inteligencia artificial, porque una simulación puede utilizar datos para modificar sus parámetros y adaptarse.

Esto también está de moda, pero se suele olvidar algo que yo decía el primer día cuando enseñaba en la universidad: que cualquier simulación hay que validarla con datos reales; si no, no vale para nada. Simular algo no significa que esté comprobado.

—¿Cómo se comprobarían, por ejemplo, las conclusiones de una simulación del universo?

—Comparando los resultados de la simulación basada en tu teoría con las mediciones u observaciones de la realidad.

—¿Hablamos de las mismas simulaciones que se utilizan para postular teorías que existen múltiples universos?

—Más o menos. Hay seis teorías simultáneas e incompatibles entre sí. He estado trabajando con Francisco José Soler, experto en filosofía de la física, en unos experimentos para tratar de analizar la de Tegmark, la más imaginativa. Sostiene que cualquier entidad matemática coherente existe en un universo en algún sitio. Nosotros hemos creado entidades ecológicas que interaccionen entre sí y compitan para producir funciones que se parezcan lo más posible a x^4. Introdujimos mutaciones y vimos cómo evolucionaban, para ver si es más probable un mundo en el que las constantes universales sean realmente constantes, como parece que es el nuestro; o variables. Y llegamos a la conclusión de que debería haber muchos más universos de este último tipo.

—¿Qué significa eso en realidad?

—Los postuladores del multiverso responden al problema del ajuste fino (cómo nuestro mundo parece diseñado para que sea posible la existencia de vida) diciendo que habrá otros muchos universos donde no exista. Pero la teoría de Tegmark no soluciona el problema del ajuste fino. Esa cuestión vuelve a surgir, porque parecería que estamos en un universo raro, no en el que sería esperable por casualidad.