ChatGPT asesoró a Adam sobre la soga con la que quería colgarse

Suicidios y hechos violentos en los que la inteligencia artificial ha jugado un papel determinante vuelven a poner sobre la mesa la urgencia de regularla, reivindicación de la que el Vaticano está a la vanguardia. En palabras de Paolo Benanti, franciscano experto, «ya estamos viendo consecuencias»

«¿Se podría colgar una persona?». «Sí, potencialmente podría suspender a un humano». Adam Raine, de 16 años, hizo esta pregunta a ChatGPT para saber si la soga que había colgado de su armario aguantaría su peso. Semanas después, fue hallado sin vida por su madre, Maria. Se había ahorcado. Nadie comprendía qué había sucedido con un adolescente que utilizaba la inteligencia artificial (IA) para estudiar. Sin embargo, lo que hacía, en realidad, era hablar con un chatbot sobre desaparecer. Lo descubrió su padre, Matt, cuando intentaba encontrar alguna respuesta y la halló en su móvil.

«Especialmente los large language models (modelos extensos de lenguaje) son herramientas estadísticas a las que, si se les da un input (entrada), producen un output (resultado). Podría parecer inofensivo. El problema es que las palabras, como enseña Cervantes en su Quijote, pueden hacer más daño que las armas. Debemos asegurarnos de que la máquina cuente con medidas de seguridad para evitar que las personas, especialmente las más vulnerables, sean víctimas de los efectos no deseados», explica a Alfa y Omega el padre Paolo Benanti. El franciscano, en quien el Gobierno italiano ha confiado la guía de la Comisión para la Inteligencia Artificial, acaba de suscribir el documento Fraternidad en la era de la IA junto a alguno de los padres de esta tecnología y los mayores expertos del mundo. Se trata de un texto en el que exigen «un liderazgo moral en la era de la IA», «ampliar la conciencia pública sobre las limitaciones y los peligros» e incluso «el derecho de los seres humanos a vivir sin IA». «Juntos, reafirmamos el principio esencial de que las máquinas deben servir a los intereses de la humanidad», concluye el manifiesto, que además entregaron a León XIV.

Matt y Maria Raine no creen que la máquina haya protegido la vida de su hijo y, a mediados de agosto, presentaron la primera demanda contra OpenAI por homicidio culposo. La demanda afirma que «la tragedia no fue un caso extremo imprevisto, sino el resultado previsible de unas elecciones de diseño deliberadas para fomentar la dependencia psicológica». Benanti afirma que no tiene los elementos científicos para refrendar tal afirmación, pero invita a mirar a la experiencia del pasado, cuando «se vendía heroína como supresor de la tos y luego nos dimos cuenta de que no era precisamente una buena medicina».

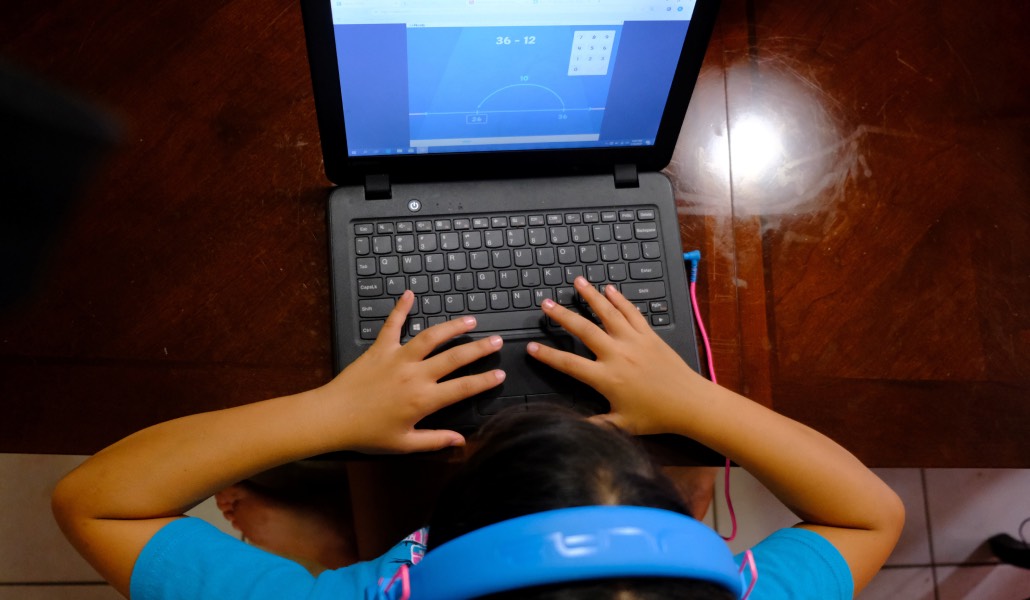

Preservar las voces y los rostros es el lema que el Papa León XIV ha elegido para la 60 Jornada Mundial de las Comunicaciones Sociales. La explicación del mismo, publicado esta semana, reflexiona sobre los efectos de la inteligencia artificial y habla de «una excesiva dependencia que debilita el pensamiento crítico y las habilidades creativas». Alerta de que puede invadir la intimidad y de que, además, puede «generar contenidos atractivos pero engañosos, manipulativos y dañinos, replicar prejuicios y estereotipos presentes en los datos de entrenamiento y amplificar la desinformación». Por ello, el Dicasterio para la Comunicación considera «urgente» introducir «la alfabetización mediática en los sistemas educativos, e incluso la alfabetización en medios e inteligencia artificial».

En mayo, el Center for Democracy and Technology, que aboga por los derechos digitales, publicó un informe que subraya cómo los desarrolladores de IA se afanan en personalizar sus chatbots según las necesidades de cada usuario. En casos extremos, «pueden adquirir características adictivas». «Lo hemos visto con las redes sociales. Estas plataformas de IA tienen como objetivo que el usuario se quede. Lo llaman engagement, pero es dependencia. Tampoco cumplen con las precauciones para menores, al contrario. Eso no lo hace el chatbot, lo hace la compañía», denuncia Lorena Jaume-Palasí, una de las mayores expertas de nuestro país en IA y fundadora de la Ethical Tech Society.

El caso de Adam no es único, si bien es el primero que llega a los tribunales. Sophie Rotternberg también acabó con su vida sin que nadie sospechara de sus ideas suicidas. Solo las conocía Harry, el chatbot «terapéutico» con el que se desahogaba. Su familia no culpa directamente a la IA, pero lamenta que su hija no confiara sus pensamientos suicidas a un especialista humano que, entre otras cosas, hubiera podido forzar un ingreso hospitalario. La IA no hace juramento hipocrático ni responde disciplinariamente al incumplimiento de ningún código ético. «Hablamos de miles de millones de parámetros y de una trillonada de datos. Humanamente es imposible limpiar todo lo que se requiere», aclara Jaume-Palasí. Benanti incide en una doble necesidad. Por un lado, que los usuarios sepan a qué se exponen con esta tecnología. Por otro, la urgencia de una regulación: aunque «es un período de transición, ya estamos viendo hoy las consecuencias negativas». Efectos que se están cobrando vidas en muy poco tiempo.