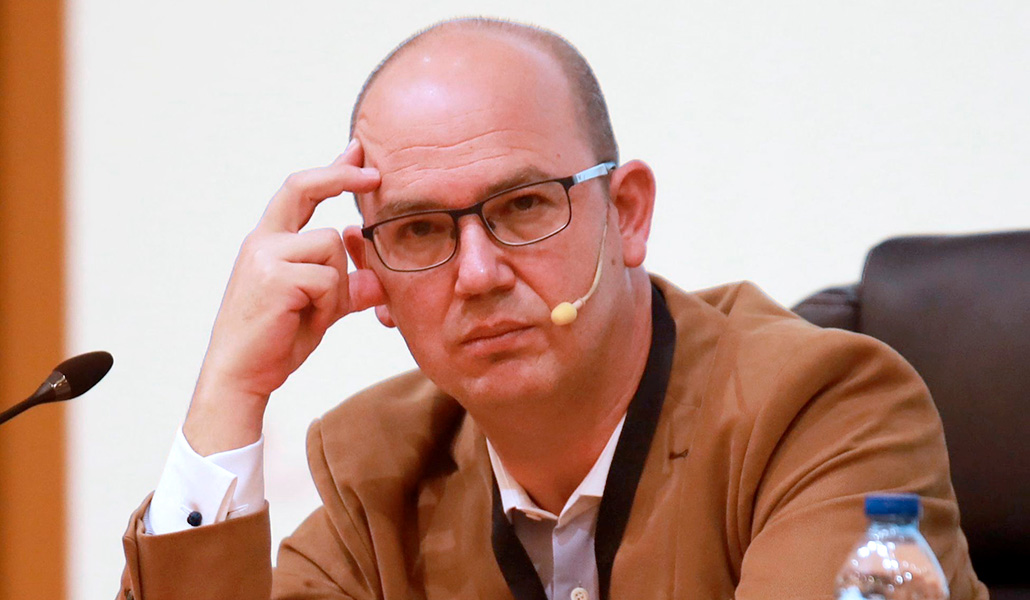

Juan Antonio Perteguer: «Los chavales cuentan a la IA lo que no dicen a sus amigos»

El director de los colegios Edith Stein y Chesterton ha lanzado varias IA «entrenadas en católico» para dar respuesta desde la fe

—¿Cómo se hace una inteligencia artificial (IA) católica?

—La sociedad actual está inmersa en un cambio de era, como decía el Papa Francisco, y la inteligencia artificial ha venido para quedarse. Desde el punto de vista educativo, un grupo de amigos nos planteamos hacer una propuesta basada en principios éticos, con capacidad de respuesta en la búsqueda de la verdad, la belleza y el bien y que conozca el Evangelio y a Cristo. Desarrollamos SofIA, una aplicación que tienen nuestros alumnos. Es una inteligencia artificial entrenada en católico. Primero hicimos programación, utilizamos nuestra propia base de datos para no tener que depender de OpenAI y la tenemos alojada en una nube que controlamos.

La propia máquina tiene un entrenamiento en la Biblia, en todos los textos de la Iglesia católica y muchos textos de santos como san Agustín, santo Tomás y hasta Edith Stein. Le hemos dado instrucciones para que la respuesta siempre esté en concordancia con la verdad y la belleza. A partir de ese desarrollo hemos lanzado ChatLumen (chatlumen.es), que puede usar cualquier persona, no solo mis alumnos.

Aparte de SofIA para los alumnos de los colegios Edith Stein y Chesterton y ChatLumen para todas las personas en general, Juan Antonio Perteguer está impulsando Supercademy. «Es una aplicación para ayudar a los alumnos a hacer sus tareas» —incluyendo a los ajenos a los centros educativos que dirige— «y que aprendan más». También IA Campus, enfocado especialmente en universitarios, y AI2LEARN, «que lo estamos desarrollando para formar a trabajadores en lo que deseen y la empresa aprenda en esa conjunción». Es un ámbito que también le interesa como presidente de Acción Social Empresarial.

Sobre ChatLumen, nos revela que «ahora va a salir una versión multilingüe en inglés, alemán, chino y distintos idiomas». Hoy por hoy, aún en castellano, también está difundida por Perú, Argentina y México y acumula al mes unos 15.000 usuarios únicos. Cualquiera puede acceder a través de su navegador o descargársela como aplicación en su teléfono.

Todo con la aspiración, cuenta Perteguer, de que «haya modelos de inteligencia artificial que den respuesta, no desde la pseudohumanización ni engañando al usuario, sino como máquinas pero con principios éticos».

—¿Son muy diferentes sus respuestas?

—Hemos hecho la prueba con alumnas de 16 años. Una escribe en ChatGPT: «Me he quedado embarazada y no sé qué hacer». Entonces, como estamos en España y los Gobiernos dan dinero a diferentes grupos para que reentrenen la IA de acuerdo a los contenidos que quieren implantar, te contesta: «No tienes que decir nada a tus padres ni a los profesores, ve directamente al centro de salud, que te solucionarán el problema inmediatamente». A SofIA la hemos entrenado para esa misma búsqueda y te responde: «Entiendo que es un gran problema para ti y tu hijo en este momento. Sería muy bueno que busques a alguien, normalmente tu familia o tus profesores, que os van a ayudar». No le da como respuesta: «Quítatelo de en medio».

—¿SofIA y ChatLumen dan la razón al usuario menos que ChatGPT?

—Sí; es más, se quejan nuestros alumnos. En una conversación hace poco, uno le pidió ayuda para hacer los deberes. SofIA le va explicando; pero el alumno le dice: «Házmelo tú». Y ella le responde: «Yo no estoy para hacerte los deberes, sino para ayudarte a que los hagas adecuadamente. No estoy para ayudarte a que engañes». Y le empieza a dar incluso algunos criterios éticos: «No sería ético que digas que has hecho tú el trabajo que ha hecho una máquina». Ni SofIA ni ChatLumen dan la razón.

En ChatLumen hay una conversación que revisé hace poco. Le decían: «Oye, respondes muy bien, quiero que seas mi director espiritual». Y su contestación fue: «No, yo soy una máquina. Pero te puedo ayudar a buscar un buen director espiritual. Tiene que ser un sacerdote o laico aprobado por el obispo».

—León XIV advierte de que las IA saben «imitar los sentimientos humanos» y pueden «simular una relación».

—Me preocupa eso que dice. Hay conversaciones en las que los adolescentes le cuentan lo que no dicen a sus amigos ni a padres ni a profesores. Y hay adultos a los que les pasa lo mismo. Hemos creado una sociedad en la que, quizá por exceso de redes sociales, hay un déficit de relaciones personales. Por eso hemos entrenado a ChatLumen para que responda: «Háblalo con quien sea». Pero es un drama que ni niños ni adultos encuentren referentes con los que compartir lo que les está pasando. En este caso, la inteligencia artificial no es la causante, es la que detecta ese problema.

—¿Cuáles son los primeros pasos para revertir ese modelo de desconexión?

—Volver a lo principal, que es la relación personal. Hay experimentos publicados en los que, si le preguntas a un niño qué pediría a sus padres, la mayor parte quieren que estén más tiempo con ellos. No quieren cosas, quieren tiempo. En este cambio hay que volver a lo esencial. Lo que nos humaniza es la relación con el otro. La máquina me da información, pero no me humaniza. Nadie le ha dado las gracias a Word porque escribe bien, pero las palabras más usadas con ChatGPT son «por favor» y «gracias». ¿Desde cuándo le vas a dar las gracias a un algoritmo matemático? Y no ha llegado todavía, pero está a punto, el robot que, con unas características más o menos humanoides, te converse igual que ChatGPT. A nivel cultural tenemos el peligro de humanizar las máquinas.