La fiebre de la inteligencia artificial (IA) ha escalado en las últimas semanas, impulsada por el celebérrimo ChatGPT y por la Eurocámara. La IA puede incluso ayudar a salvar vidas. Aunque también podría emplearse para manipularnos, para romper nuestra intimidad o la igualdad ante la ley. Así que, antes de que se vuelva ingobernable, la UE ha puesto en marcha su fábrica normativa. La Comisión Europea dio los primeros pasos y la Eurocámara le ha tomado el relevo. Después vendrán las conversaciones con el Consejo de la UE, de modo que en 2026 podamos tener en vigor una ley europea de IA.

Ahora bien, Luc Julia, creador de Siri, advierte que «la inteligencia artificial no existe». ¿Sorprendente? Veamos. A mediados del siglo pasado se intentó una IA basada en la lógica, pero hacia los años 70 topó con límites infranqueables. Tras la difusión masiva de los PC y la aparición de internet, se ha relanzado el proyecto de IA, esta vez apoyado en la estadística. Únase a ello que la capacidad de computación se ha multiplicado y abaratado enormemente. Sobre estas bases crece la nueva IA, compuesta por algoritmos que no entienden nada. Tan solo buscan correlaciones entre la jungla de datos que nosotros regalamos a las grandes corporaciones.

El software GPT es tan tonto como el aspirador que recorre el pasillo. Ambos acabarán como la supercomputadora Deep Blue, criando polvo de museo. Estamos hoy tan lejos de la llamada IA general como lo estábamos hace medio siglo. La cuestión no es tecnológica, es ontológica. Pensar, lo que se dice pensar, es algo que hacemos solo las personas.

¿Entonces, qué queremos decir cuando descuidadamente hablamos de IA? Nos referimos a los sistemas de IA. Estos son sistemas sociales en los cuales participan máquinas, no meramente sistemas artificiales con consecuencias sociales. El cambio de perspectiva es crucial. Los sistemas de IA están compuestos por máquinas… y por personas. Su parte inteligente no es artificial y su parte artificial no es inteligente. La inteligencia brota en el momento en el que una persona actúa sobre una máquina. La diseña, desarrolla, entrena o mantiene, la emplea o legisla sobre sus posibles usos. La máquina, dejada a sí misma, es un simple sistema físico carente de intencionalidad. Cuando nadie mira la pantalla, en la pantalla no hay letras, sino luces. Cuando Andy sale del cuarto, los juguetes no siguen jugando solos; aunque, subyugados por lo que podríamos llamar efecto Toy Story, algunos persistan en la búsqueda de la máquina pensante. Todo lo digital, metaverso incluido, entra en la realidad como representación ante los ojos de alguien. Si falta ese alguien, lo digital pierde su carácter de representación y colapsa en mero hecho físico.

El nombre IA es desorientador, aunque rinda bien para recabar fondos y sirva como llamador de musas a literatos y cineastas. «Surgió en los años 50 —recuerda Katharina Zweig, de la Universidad de Kaiserslautern—, cuando los científicos querían recaudar dinero para sus investigaciones. Y ahora pendemos de este nombre. La mayoría de los científicos informáticos lo encuentran inapropiado». Quizá ya no estemos a tiempo de cambiarlo, pero sí al menos de despejar la nube conceptual que lo envuelve.

Los sistemas llamados de IA son simplemente sistemas de control delegado (sistemas CoDe). Por decisión humana, ponemos ciertos procesos bajo el control de un artefacto. Puedo ceder el control del avión al piloto automático o la redacción de un documento a un sistema de IA generativo. El enfoque CoDe es mucho más lúcido que el enfoque IA. Nos invita a hacer las preguntas adecuadas, a buscar la mano que mece la máquina, los intereses que hay detrás de la misma. Humanos, por supuesto, y a veces demasiado humanos.

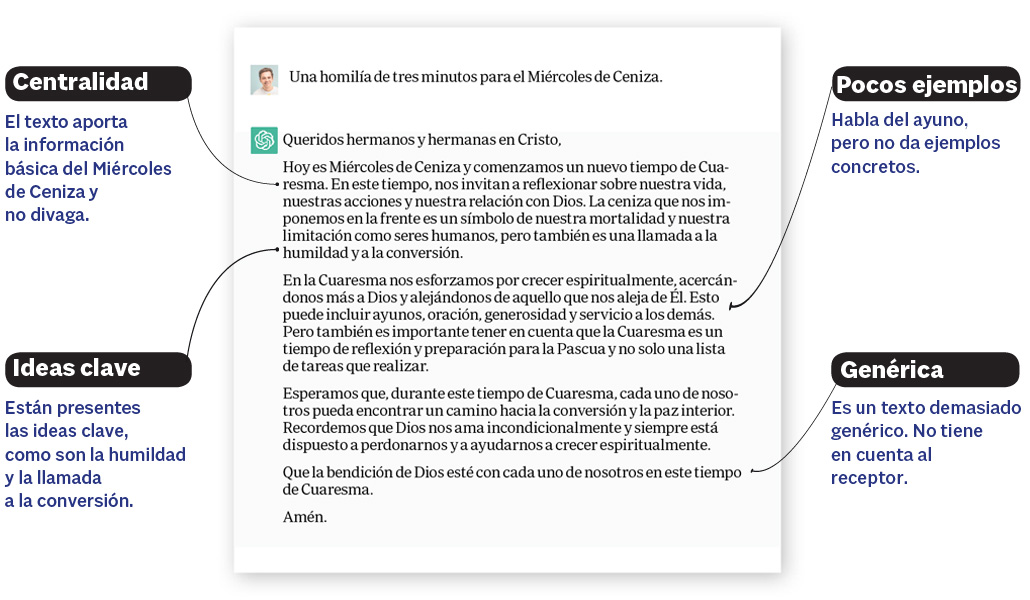

La propuesta de la Eurocámara jerarquiza los riesgos de los sistemas de IA. Prohíbe los de riesgo inaceptable, establece cautelas severas para los de alto riesgo, pide etiquetado a los que implican un riesgo bajo y deja a su albur el resto. Desde el enfoque CoDe podemos dar claridad a este proceder. Cuando el proceso que queremos delegar es ilegítimo, la delegación ha de estar prohibida. La ley ha de prohibir procesos de manipulación de menores, de vigilancia masiva o de clasificación social discriminatoria, se hagan o no con delegación del control en máquinas. Ha de establecer cautelas para procesos que impliquen riesgos altos, restringiendo la delegación total y ciega de su control, por ejemplo, en lo que hace al manejo de infraestructuras críticas o al ejercicio de la justicia, la educación o la medicina. En otros terrenos, como puede ser el de generación de contenidos mediáticos, se puede ser más laxo con tal de que el consumidor sepa de su autoría mecánica. No se trata de embridar la supuesta peligrosidad de las máquinas, sino de legislar, como se ha hecho siempre, sobre las relaciones entre personas, y a ser posible a favor la dignidad de las mismas.

La ley europea nace con intención de liderazgo mundial. Pero la IA está hoy en manos de media docena de corporaciones norteamericanas y del Partido Comunista Chino. No nos vendría mal, pues, un decidido activismo a favor de la fragmentación de las grandes empresas del sector y en contra del comunismo chino, armado además ahora con el nuevo poder algorítmico. Todo ello ha de ser tarea simultánea a la proclamación de leyes. Sin afrontarla, cualquier legislación europea restrictiva servirá solo para hacer aún más irrelevante a Europa en el concierto de la IA. Quizá incluso para desplazar sus desarrollos más inquietantes hacia países frágiles.